Ein Team von drei Robotern der Queensland University of Technology (QUT) hat einen schnelleren und genaueren Weg entwickelt Roboter greifen in Echtzeit nach Objekten und öffnen Türen für Anwendungen in Industrie- und Wohnumgebungen.

Ihr Krepppapier wurde auf der internationalen Robotikkonferenz der Carnegie Mellon University vorgestellt, Robotik: Wissenschaft und Systeme, letzte Woche.

Baby Schritte unternehmen

Niemand kann leugnen, dass die Robotik der Weg der Zukunft ist. Laut Internationale DatengesellschaftDie weltweiten Ausgaben für Robotik werden von 135 2019 Milliarden US-Dollar erreichen.

Während Roboter seit langem menschliche Arbeit in Fließbändern und Berechnungen ersetzen und sogar anfangen, wie Menschen in Schach und Debatten zu sehen, zu hören und zu denken, können Roboter eines nicht ganz erfassen - das Aufnehmen eines Objekts in einer unstrukturierten Umgebung.

Selbst für Menschen, obwohl unbemerkt, ermöglichen Tausende von Sensoren in menschlichen Fingern und ein komplexes Netzwerk von Schaltkreisen im menschlichen Gehirn, dass ein drei Monate alter Mensch seine Spielzeugrassel wahrnimmt. Er benötigt jedoch offensichtlich keine Stunden Training oder Hunderte von Forschern, um ihn zu unterrichten.

Für Roboter ist es jedoch äußerst schwierig, Objekte in unstrukturierten Umgebungen zu greifen. Um jedoch in der Nähe von Menschen nützlich zu sein, müssen Roboter wissen, wie sie sich an veränderte Umgebungen anpassen können.

Das QUT-Team hat eine neue Methode entwickelt, mit der Roboter zufällig bewegte Objekte schneller und genauer erfassen können.

"Wir sind daran interessiert, Roboter zu entwickeln, die nützliche Aufgaben in der realen Welt erfüllen. Ich war eine Weile daran interessiert, Roboter dazu zu bringen, robust mit der Welt zu interagieren, Objekte aufzunehmen und sie richtig zu platzieren “, sagte er Jürgen Leitner, ein Postdoktorand an der QUT's Fakultät für Naturwissenschaften und Ingenieurwissenschaften. "Es stellt sich heraus, dass einige Dinge, die für uns schwierig sind, für Computer einfach sind, wie zum Beispiel Schach, während einige Dinge, die für uns einfach sind, für Roboter sehr schwierig sind, wie zum Beispiel Greifen."

Der neue Ansatz

Mithilfe von Deep-Learning-Techniken können Roboter aus Tausenden von Größen und Formen lernen, um die beste Methode zum Erfassen eines unbekannten Objekts in einem statischen Zustand zu berechnen.

Ein Roboter mit CNN (Convolutional Neural Network), der am weitesten verbreiteten Methode zur Objekterkennung, tastet Objekte einzeln ab und ordnet sie nach bestmöglichem Grip. Diese Technik benötigt jedoch auch in statischen Umgebungen eine lange Rechenzeit.

Die Methode der Forscher basiert jedoch auf einem generativen, faltungsorientierten neuronalen Netzwerk (GG-CNN), das seine Umgebung direkt abtastet und jedes Pixel, das es erfasst, anhand eines Tiefenbilds abbildet und schnell genug ist, um sich bewegende Objekte zu erfassen.

„Der Ansatz des Generative Grasping Convolutional Neural Network funktioniert, indem die Qualität und die Haltung eines Zweifingergriffs für jedes Pixel vorhergesagt wird. Indem der Roboter in einem Durchgang mithilfe eines Tiefenbilds das Davor befindliche abbildet, muss er nicht viele verschiedene mögliche Griffe abtasten, um eine Entscheidung zu treffen. Dadurch werden lange Rechenzeiten vermieden “, sagte Douglas Morrison, ein QUT-Doktorand in einem Aussage.

Während ihr vorheriger Roboter, der die Amazon Picking Challenge in 2017 gewonnen hatte, einfach in einen Behälter mit Objekten schaute, den bestmöglichen Grip berechnete und blind einstieg, um sie aufzunehmen, verarbeitet ihre aktualisierte Version Bilder der Objekte innerhalb von etwa 20 Millisekunden.

Laut Leitner platziert der aktuelle Roboter nach dem Aufnehmen von Objekten diese an einem festen Ort und beginnt, nach dem nächsten Gegenstand in der Szene zu suchen.

Die unvorhersehbare Welt

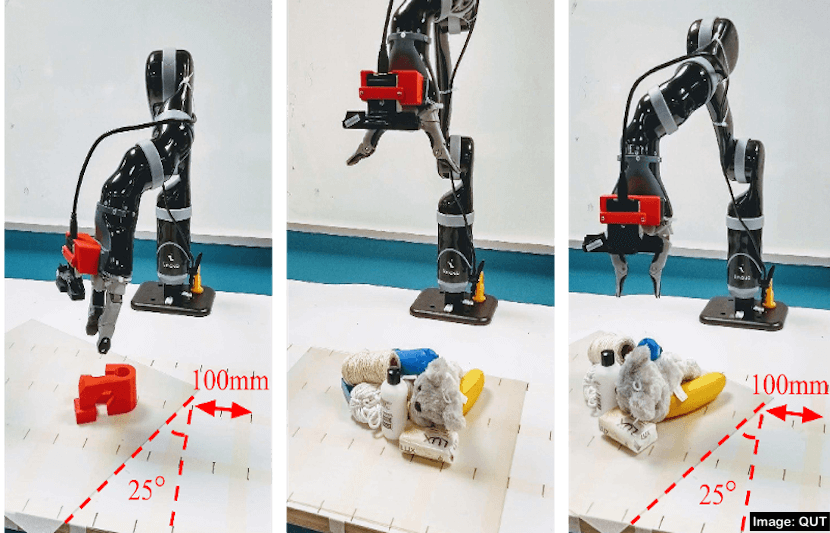

Die Forscher testeten ihren neuen Ansatz auf verschiedene Weise.

"Es gab verschiedene Versuchsanordnungen, alle mit realen Robotern und Objekten", sagte Leitner. "Wir haben mit einer Reihe von 'Haushaltsobjekten', 3D-Druckobjekten, getestet und den Ansatz mit verschiedenen Geräuschpegeln in der Robotersteuerung überprüft."

Zunächst führten sie 10-Versuche durch, um unsichtbare Objekte mit kontradiktorischer Geometrie und Haushaltsobjekte sowohl in statischen als auch in beweglichen Umgebungen zu erfassen.

Während der Roboter in einer statischen Umgebung eine Erfolgsrate von 84 Prozent für die gegnerische Geometrie und 92 Prozent für Haushaltsgegenstände erzielte, erreichte er in einer sich bewegenden Umgebung 83 Prozent bzw. 88 Prozent.

Zweitens mischten sie 10-Testobjekte in einer Schachtel und gossen sie auf einen überfüllten Stapel unter dem Roboter, damit er sie einzeln greifen konnte. Anschließend führten sie 10-Versuche zum Erfassen sowohl in statischen als auch in beweglichen Umgebungen durch.

Während der Roboter in einer statischen Umgebung eine Erfolgsrate von 87 Prozent erreichte, erreichte er in einer sich bewegenden Umgebung eine Erfolgsrate von 81 Prozent.

„Mit dieser neuen Methode können wir Bilder der Objekte verarbeiten, die ein Roboter innerhalb von etwa 20 Millisekunden anzeigt. Auf diese Weise kann der Roboter seine Entscheidung, wo ein Objekt ergriffen werden soll, aktualisieren und dies mit viel größerem Zweck tun. Dies ist besonders wichtig in überfüllten Räumen “, sagte Letiner in einer Erklärung.

Der nächste Schritt

Die Forscher hoffen, ihre Methode weiter zu verbessern, mit der Roboter sicherer und umfassender im Umfeld von Menschen in Industrie und Haushalt eingesetzt werden können.

„Diese Forschungslinie ermöglicht es uns, Robotersysteme nicht nur in strukturierten Umgebungen einzusetzen, in denen die gesamte Fabrik auf Roboterfähigkeiten basiert“, sagte Leitner in einer Erklärung. „Dies hat Vorteile für die Industrie - von Lagern für Online-Einkäufe und -Sortierungen bis hin zur Obsternte. Es könnte auch zu Hause eingesetzt werden, da intelligentere Roboter nicht nur zum Saugen oder Wischen eines Bodens entwickelt werden, sondern auch zum Aufnehmen und Ablegen von Gegenständen. “

Sie arbeiten auch daran, einige der Einschränkungen des aktuellen Ansatzes zu überwinden, wie beispielsweise das Robotersehen und die Manipulationsfähigkeiten in einer Vielzahl von Umgebungen, so Leitner.

Derzeit planen sie die Organisation einer „Robotic Tidy Up My Room Challenge“.